生成AIをクラウドではなく自分のパソコン上で動かしたいというニーズも高まっています。そのためには「ローカルAIは高性能PCが必要」と思っていませんか?

実は工夫すれば、低スペックPCでも軽量なモデルを使って生成AIを試せる方法があります。

本記事では、話題の「Ollama」というツールを活用して、Windowsなどの低スペックPC上でローカル生成AIを動かす手順を、初心者向けにわかりやすく解説します。

ダウンロードからインストール、モデル選びのコツまで具体的に紹介しますので、この記事を読めば誰でもローカルAIの世界に一歩踏み出せるでしょう。

低スペックPCでも、工夫次第でローカル生成AIを動かすことは可能です。ollamaを使えば、使い古しのPCをローカル生成AI専用にすることも可能になりますよ。

ローカルでAIが動かせるなんてすごい!でも私のPCはメモリ12GBしかないし、ちゃんと動くのかな…?

Ollamaとは?

軽量で高速なローカル推論環境を提供する

Ollama(オラマ)は、軽量で高速なローカル推論環境を提供するオープンソースのツールです。macOSやWindows、Linuxに対応しており、コマンド一つで生成AIモデルをダウンロード・実行できます。

そもそもローカル生成AIとは?

ローカル生成AIというのは、インターネットを介さず、PC本体で直接AIモデルを動かす仕組みです。クラウド利用と違い、通信環境に左右されずプライバシー面でも安心できるところが最も大きなポイントです。

低スペックPCでもOllamaが使える理由

ollamaには以下のような特徴があるため、工夫次第で低スペックPCで利用ができます。

- モデルサイズを選べる(数百MB~数GB)

- GPUがなくてもCPUで動作可能(ただし速度は落ちる)

- コマンド操作がシンプル

Ollamaのインストール手順

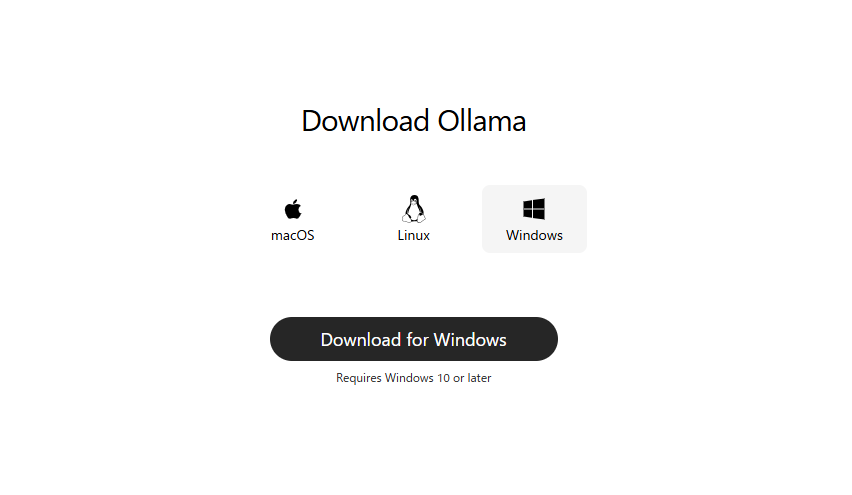

Windowsでのダウンロード

Ollama公式サイト(https://ollama.com/download)にアクセスし、Windows用インストーラーをダウンロードします。

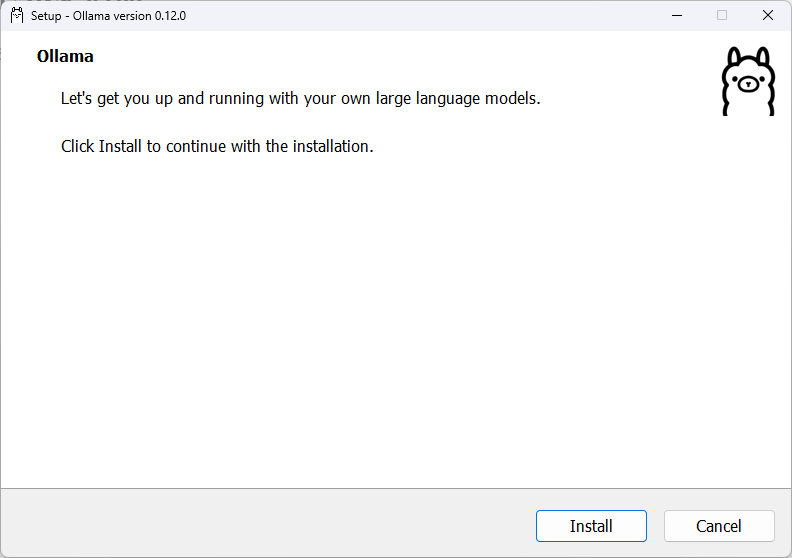

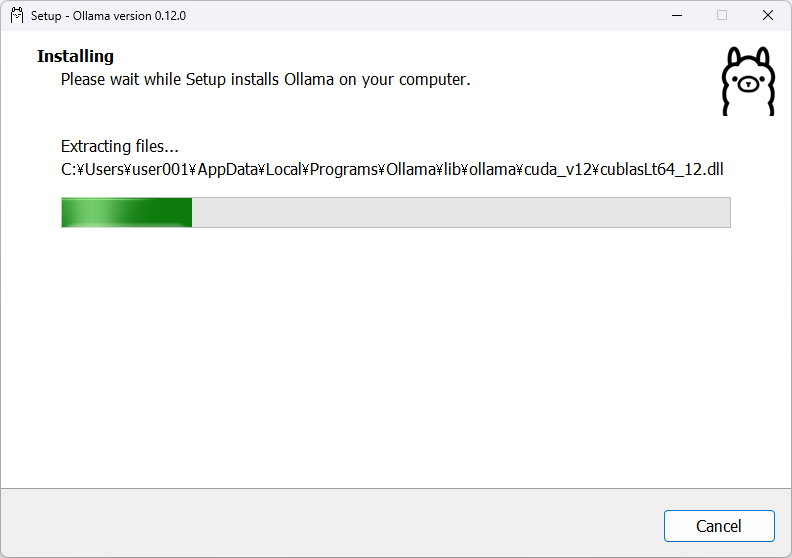

インストーラーを実行してセットアップを開始します。

ユーザーフォルダ内にインストールされます。

インストールはこれで完了です。以下のようなOllamaのGUI画面が自動起動します。(なお、この時点でインストーラーがPATHを自動設定するため、コマンドプロンプトからollamaコマンドが使えるようになります。)

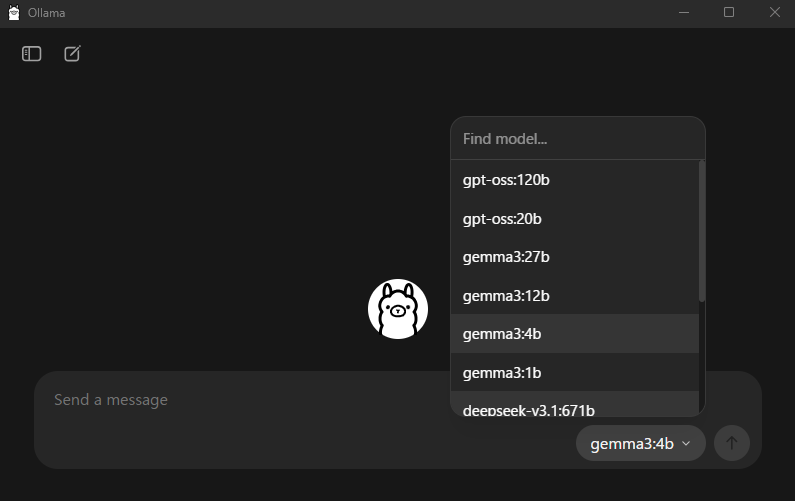

このOllamaのGUI画面では、下図のようにモデルを選択して質問ができるようになっています。

ですが、質問を投げた時点で選択されているモデルが自動でダウンロードされる仕組みになっていますので、ここでは触りません。画面を×で閉じましょう。(GUI上で選択できるモデルに低スペックPC向けのものはありません)

低スペックPC向けのモデルを取得する

低スペック向けPC向けモデルの選定

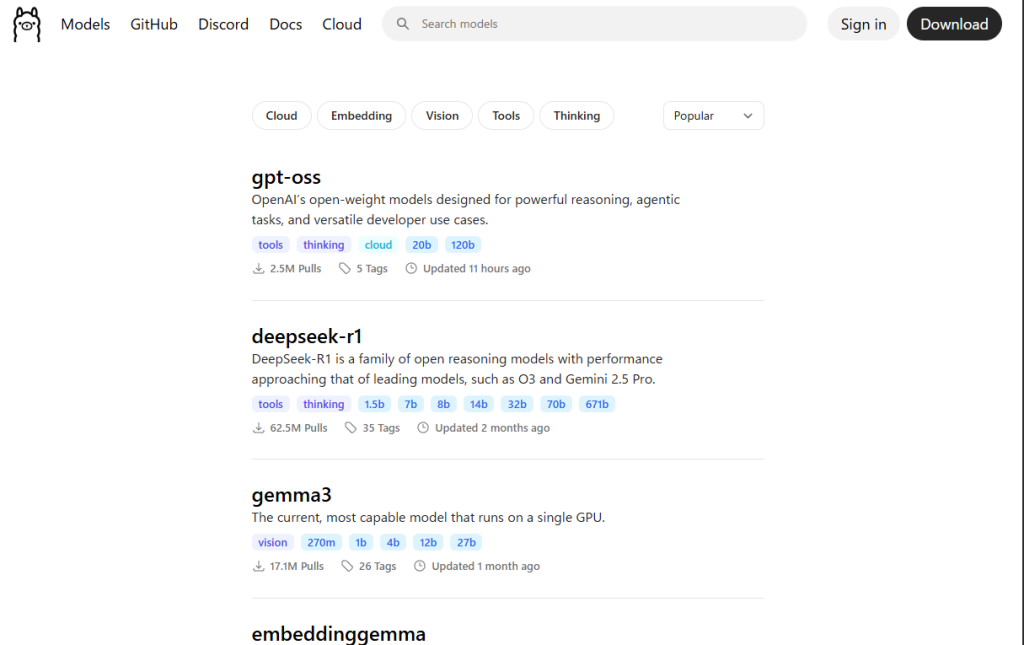

今回は自分で目的のモデル(低スペックPC向け)を取得したいため、https://ollama.com/search へアクセスします。

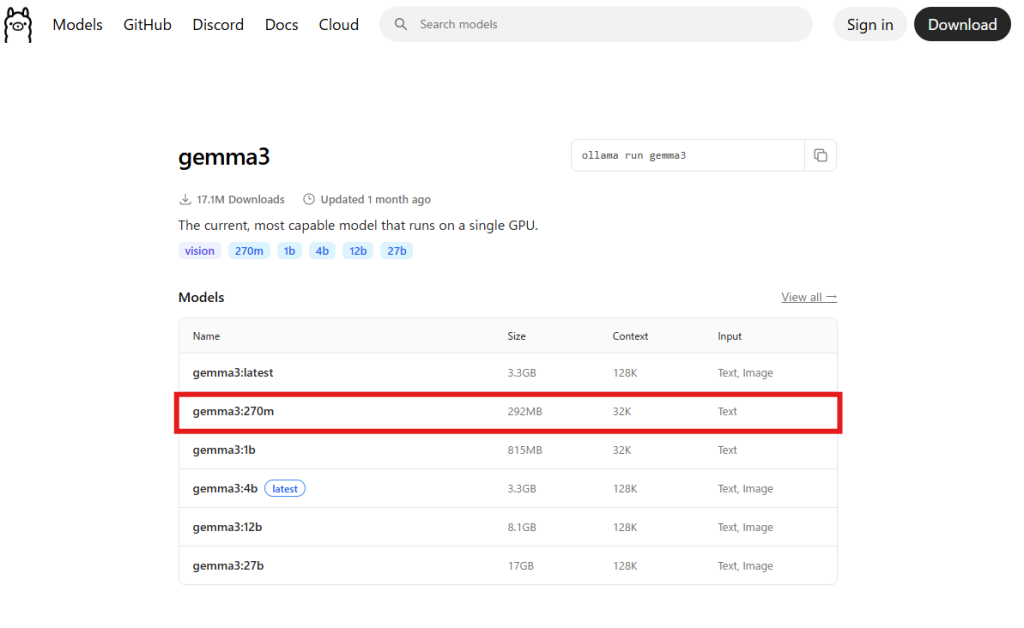

モデルを見ていくと、gemma3には、なんと「270m」という超軽量モデルが存在します。今回は低スペックPC向けですので、これで行きましょう。

そもそも270m・1b・4b…ってなに?

Ollamaでモデルを選ぶときに出てくる「270M」「1B」「4B」「12B」「27B」といった表記は、AIモデルの大きさ(パラメータ数)を示しています。パラメータとは、AIモデルが文章を理解・生成するために使う「重みデータ」で、この数が多いほど学習量が豊富になり精度が高くなる傾向があります。

- 270M:約2億7千万パラメータ。軽量・高速。低スペックPCでも動作しやすい。文章精度は控えめ。メモリ8GB〜。CPUのみでも可

- 1B:約10億パラメータ。バランス型。ある程度の知識量と自然さ。メモリ12GB前後。CPUまたは軽めのGPU。

- 4B:約40億パラメータ。精度高め。長めの文章や多様な話題に強いが、重め。メモリ16GB以上。GPU推奨

- 12B:約120億パラメータ。高精度・高知識。GPT-3系に近い体感。メモリ24GB以上。VRAM8GB以上のGPUを推奨。

- 27B:約270億パラメータ。非常に高精度だが負荷大。商用グレードに近い性能。メモリ32GB以上 。VRAM16GB以上のGPUが必須。

パラメータ数の目安

- 数が大きい=知識量・表現力が増えるが、そのぶん処理が重くなる

- 数が小さい=軽快に動くが、知識や文章力は限定的

初心者の方はまず270Mや1Bなどの軽量モデルから試し、慣れてきたら4Bや12Bにステップアップするのがおすすめです。27BはハイスペックGPU搭載機かクラウド環境向けです。

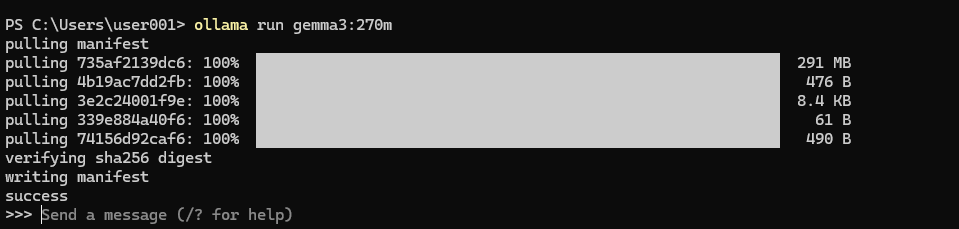

PowerShellでモデルのダウンロード

ダウンロードしたいモデルが「gemma3の270m」に決まったところで、PowerShellを起動して、以下のコマンドを実行しましょう。(コピペでOKです)

ollama run gemma3:270mダウンロードが始まります。

ダウンロードが終わったら、そのままプロンプトを打てるような状態になります。

低スペックPC向けモデルの使い勝手は?

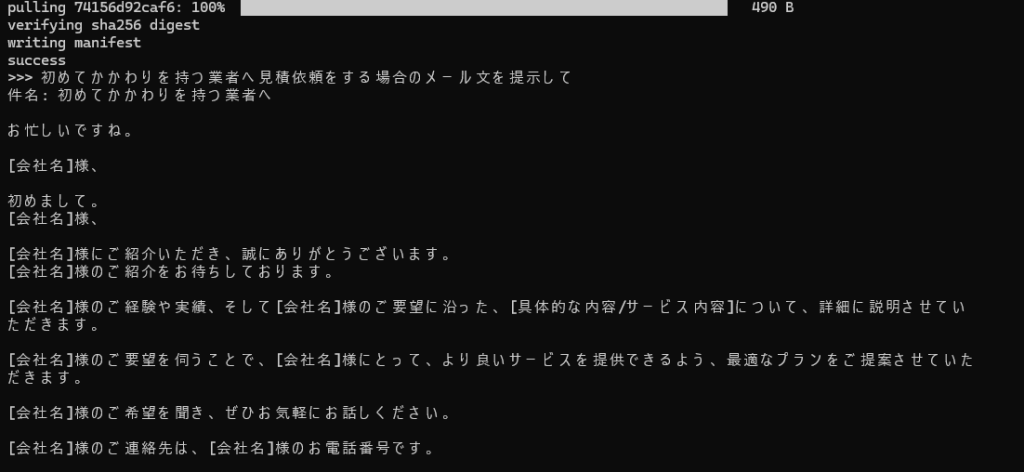

gemma3:270mの回答

早速試してみます。

あえて細かい指定をせずに、以下のようなざっくりした質問を投げてみました。

初めてかかわりを持つ業者へ見積依頼をする場合のメール文を提示して

結果は以下のようなものが返ってきました。

なかなか実務として使えるレベルにするには難しそうな印象はあります。

ただし、これはモデルサイズ(パラメータ数)の違いによる当然の結果でもあります。270Mは軽量・高速性を重視したモデルで、応答スピードやローカル動作のしやすさは抜群ですが、知識量や文章の自然さはどうしても制限されます。

逆に言えば、「動作が軽い」「ローカルで気軽に試せる」という大きなメリットがあるため、最初の一歩としては最適です。必要に応じて1Bや4Bのモデルにステップアップすれば、より自然な応答に近づけるでしょう。

参考までにGPT-5の回答

参考までに、全く同じプロンプトをGPT-5に投げた場合の回答は以下のような感じです。

もちろんです!

初めて取引する業者さんへの見積依頼メールは、以下のようにすると丁寧かつ必要な情報がしっかり伝わります。

件名例

- 【見積依頼】○○(商品・サービス名)について

- 【お見積りのお願い】○○のご提案

本文例

○○株式会社 ○○部 ○○様 突然のご連絡失礼いたします。 私、△△(あなたの会社名・部署名)の□□(氏名)と申します。 このたび、貴社にて取り扱われている「○○(商品・サービス名)」について、 見積書のご提出をお願いしたく、メールを差し上げました。 下記条件にてお見積りいただけますでしょうか。 ──────────────────────── 【見積依頼内容】 ・商品/サービス名:○○○ ・数量/期間:○○○ ・納期希望:○○○ ・その他条件:○○○ ──────────────────────── お忙しいところ恐れ入りますが、○月○日(○)までに ご回答いただけますと幸いです。 何かご不明点や追加情報が必要な場合は、お知らせください。 どうぞよろしくお願い申し上げます。 ──────────────────────── 会社名:△△△株式会社 部署名:□□部 氏名:□□□ 電話:03-XXXX-XXXX メール:xxxx@example.co.jp ────────────────────────ポイント

- 冒頭で「初めての連絡」であることを伝える

- 見積条件を箇条書きで明確に記載

- 回答期限を設定

- 連絡先を明記

必要に応じて、もう少しカジュアルなパターンもお作りできますが、

まずは↑のようなフォーマルな形が一般的で安心です。

希望があれば、

- もっとカジュアル

- 官公庁向け(もっと堅め)

- 英語版

などのバリエーションもご提案できますが、どれに近い感じがよいですか?

よくあるトラブルと対処法

モデルが重すぎて動かない

軽量モデルを選び直すか、スワップ領域を増やす。

コマンドが認識されない

一度PCを再起動するか、PATH設定を確認。

出力が遅い

CPU利用時はどうしても遅い。モデルを小さくするか、GPU対応環境を検討。

ollamaと他ツールの違い

- LM Studioやtext-generation-webuiに比べ、Ollamaはインストールが簡単

- CLI中心だが、API連携も可能で拡張性が高い

まとめ

Ollamaは、ローカル生成AIの入門として非常に扱いやすいツールです。

特に低スペックPCユーザーでも、軽量モデルを選ぶことで十分試すことができます。プライバシー面の安心感やネット環境に左右されないメリットもあり、今後ますます注目されるでしょう。

まずは小さなモデルから始め、慣れてきたら大きなモデルに挑戦するのがおすすめです。もちろんそのためには高スペックPCが必要にはなりますが…。

最初は軽量モデルで感触をつかみ、少しずつ環境を整えていくことが大切です。自分のPCで生成AIを動かす楽しさをぜひ体験してください!

コメント